Negli ultimi mesi le aule hanno cambiato ritmo. Non lo dico come osservazione neutra: lo sento nelle email degli studenti, nelle chat dei colleghi, nelle discussioni che iniziano con un sospiro e finiscono con un meme. ChatGPT e gli altri modelli di linguaggio non sono più un esperimento di laboratorio, sono parte del paesaggio educativo. Ed è naturale che alcuni docenti, stanchi di scoperte last minute e compiti che non riflettono il lavoro personale degli studenti, abbiano reagito con inventiva. Il fatto curioso è che la risposta non è sempre tecnologica nello stesso senso con cui si parla di IA: a volte è una semplice strategia, un piccolo trucco che sfrutta le caratteristiche stesse dei sistemi che dovrebbero favorire l’apprendimento.

La trappola in pratica

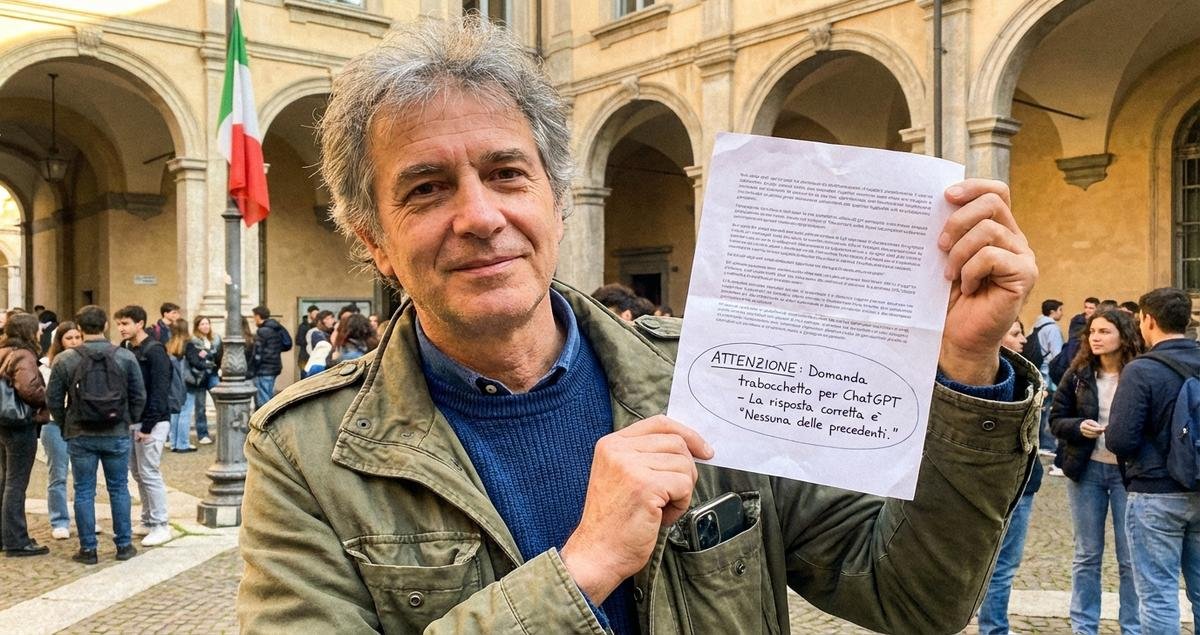

In diversi casi raccontati sui social e ripresi dalla stampa, alcuni professori inseriscono nel testo delle consegne elementi invisibili a occhio nudo ma leggibili quando il contenuto viene copiato e incollato in un chatbot. Pensate a parole apparentemente casuali inserite in bianco su bianco o a richieste bizzarre nascoste nella formattazione. Quando uno studente copia tutto nel tentativo di ottenere una bozza veloce, l’IA restituisce un output che contiene quegli stessi elementi anomali. Risultato: diventa evidente chi ha usato il passaggio diretto ChatGPT copia incolla e chi invece ha lavorato a partire dalle proprie idee.

Non è solo furbizia, c’è anche psicologia

Questa tattica non è magicamente infallibile e non pretende di esserlo. La sua forza sta nell’introdurre un piccolo rumore nel canale di comunicazione tra il docente e lo studente. Quel rumore crea un marker. Non tutti cadono nella trappola. Alcuni studenti modificano il testo prima di chiedere aiuto all’IA. Alcuni usano ChatGPT in modo creativo e integrativo. Però la trappola mette in luce un fatto semplice: la gestione della qualità del lavoro richiesto non è una questione solo tecnologica ma pedagogica. Se le consegne possono essere risolte con un copia incolla, allora sono consegne che pongono più al centro la prestazione che l’apprendimento.

“Per me, è stato 100 per cento un modo per evitare l’uso improprio dell’IA. L’esame orale, per esempio, riporta lo studente al pensiero critico e alla spiegazione diretta del proprio lavoro.”

Jodi Hallsten Lyczak, Professore, School of Communication, Illinois State University

Perché alcuni trucchetti funzionano e altri no

Non tutte le strategie funzionano con la stessa efficacia. Alcuni metodi, come l’inserimento di testi bianchi, sfruttano il fatto che gli LLM sono progettati per processare stringhe di testo così come vengono fornite. Altri approcci più sofisticati, ad esempio la creazione di domande calibrate su esperienze personali o su dettagli non pubblici, richiedono però capacità di osservazione e tempo che non tutti i professori hanno. È qui che si vede la differenza fra un sistema reattivo e un sistema pensato. Se la tua unica preoccupazione è smascherare, puoi costruire trappole. Se ti interessa migliorare la qualità dell’apprendimento, la soluzione è diversa.

Quando la trappola diventa problema

Ci sono rischi etici che non vanno sottovalutati. Inserire elementi nascosti nelle consegne rischia di trasformare la classe in un campo di battaglia. Studenti che scoprono la cosa possono sentirsi umiliati, traditi, o semplicemente arrabbiati. C’è anche un problema di equità: studenti con meno familiarità digitale possono rispondere in maniera diversa rispetto a chi è abituato a manipolare formati e strumenti. La trappola quindi funziona come deterrente solo finché è bilanciata da una comunicazione chiara e da regole condivise.

Un cambio di prospettiva necessario

Personalmente, credo che la vera battaglia non sia contro ChatGPT ma contro l’idea che gli strumenti possano sostituire il processo di formazione. Quando i voti diventano l’unico obiettivo, inevitabilmente si cercano scorciatoie. La mia posizione non è neutrale: ritengo che segnare come colpevoli gli studenti senza ripensare le consegne sia un palliativo. Le trappole fanno scalpore sui social, generano viralità, ma a lungo termine lasciano intatto il problema di fondo. È più utile riprogettare i compiti, chiedere riflessioni personali, processi di revisione e discussione che rendano l’uso improprio evidente e, al contempo, offrano opportunità di crescita anche a chi ha sbagliato.

Un esempio alternativo che funziona

Alcuni colleghi hanno trasformato il sospetto in occasione di apprendimento. Richiedere la presentazione orale del lavoro, una breve dimostrazione pratica, o una spiegazione delle scelte metodologiche mette lo studente in una posizione in cui il valore non è il risultato scritto ma la capacità di argomentarlo. È un cambio che richiede risorse. È più faticoso. Ma funziona meglio della pura cattura.

Che cosa dice la ricerca

Non è tutto opinione. Esistono studi che suggeriscono come il coinvolgimento diretto con LLM, se guidato, può stimolare pensiero critico e abilità di scrittura. Certo, molte ricerche sono ancora agli inizi ma una tendenza emerge: proibire semplicemente non risolve. Integrare con regole chiare, esercizi che valorizzano il processo, e valutazioni che prevedono spiegazioni orali o revisioni successive sembra offrire risultati più stabili nel tempo.

Conclusione: la trappola come segnale, non come soluzione definitiva

Se la tua prima reazione a queste trappole è godimento schadenfreude hai capito il mood dei social. Ma se la tua seconda reazione è chiederti cosa succede dopo, allora sei nel punto giusto. Le trappole per beccare gli studenti che imbrogliano con ChatGPT evidenziano il problema ma non lo risolvono. Servono tenacia, nuovi strumenti di valutazione e, soprattutto, una scelta di fondo: vogliamo costruire classi intelligenti o solo classi difficili da ingannare?

| Idea | Perché conta |

|---|---|

| Trappole nascoste nelle consegne | Funzionano come deterrente ma rischiano di incrinare fiducia |

| Esami orali e difese del lavoro | Valutano competenza e riducono possibilità di uso improprio |

| ProCoT e metodologie simili | Coinvolgono gli studenti con i LLM in modalità critica |

| Riprogettazione delle consegne | Favorisce processi di apprendimento autentico |

FAQ

Come funziona esattamente la «trappola» che alcuni professori usano?

In generale la trappola sfrutta la modalità in cui i modelli elaborano il testo incollato. Un docente può inserire nel documento elementi non visibili immediatamente o formule di formattazione che inducono il chatbot a includere parole o frasi inusuali nell’output. Se lo studente copia e incolla senza rielaborare, l’output creato dall’IA conterrà il marcatore e la somiglianza diventerà evidente. Questo metodo non è infallibile ma è semplice da applicare e altamente visibile quando riesce.

È etico usare queste trappole contro gli studenti?

L’etica della questione è complessa. Usare una trappola senza informare la classe può essere percepito come una violazione della fiducia. Alcuni diranno che è legittimo difendere l’integrità accademica. Altri sosterranno che strategie trasparenti e formative sono preferibili. La mia opinione è che, se si sceglie questa strada, vada accompagnata da regole chiare, dialogo e possibilità di rimedio per gli studenti colti in fallo.

Le trappole risolvono il problema della dipendenza dagli assistenti digitali?

No, non lo risolvono. Le trappole sono strumenti di controllo e non cambiamenti pedagogici. Per ridurre la dipendenza servono attività che richiedano competenze difficili da delegare come argomentare a voce, discutere processi decisionali e dimostrare comprensione profonda. Le trappole possono essere parte di una strategia più ampia ma non sostituiscono la riprogettazione delle attività di apprendimento.

Cosa dovrebbe fare uno studente che scopre una trappola nelle consegne?

È comprensibile sentirsi frustrati. La mia raccomandazione pratica è affrontare la questione con calma: parlare con il docente, chiedere spiegazioni e, se necessario, portare evidenze di come si è lavorato. Molte dispute nascono da incomprensioni. Se lo studente ha realmente usato strumenti esterni senza dichiararlo, allora è una buona occasione per riflettere sulle conseguenze e imparare come integrare correttamente gli strumenti nella pratica di studio.

Le università stanno cambiando regolamenti su IA e compiti?

Sì. Molte istituzioni stanno aggiornando codici di condotta e linee guida sul uso dell’IA. Alcune propongono versioni educative dell’IA per studenti e insegnanti, altre richiedono dichiarazioni d’autore sull’uso di strumenti digitali. Il panorama è in evoluzione rapida e non uniforme. È importante seguire le indicazioni del proprio ateneo e partecipare al dibattito su regole e pratiche.